Desde que escribí el artículo anterior hablando sobre cómo la IA se está convirtiendo en el intermediario invisible de casi todo, no dejo de preguntarme… si la IA cada vez filtra más lo que ve el usuario, ¿a quién va dirigido realmente nuestro trabajo?

Hasta ahora la respuesta parecía obvia porque siempre diseñamos para personas concretas, con necesidades, frustraciones y deseos. Observamos, empatizamos, proponemos soluciones pensadas para alguien que interactúa directamente con lo que creamos.

Pero ese escenario se está desvaneciendo poco a poco. Hoy, cada vez más, la primera experiencia que muchos tienen con un producto no llega desde nuestra interfaz, sino a través del resumen de una IA, una recomendación automatizada o el resultado priorizado en un feed algorítmico. El filtro entre lo que diseñamos y la persona ya no es humano, es una máquina que interpreta, reordena y decide qué mostrar, cómo hacerlo y cuándo.

Esto plantea una ruptura completa del sistema. Durante décadas hemos perfeccionado el diseño centrado en el usuario, pero ¿qué pasa cuando el usuario ya no es el destinatario directo de nuestro trabajo?

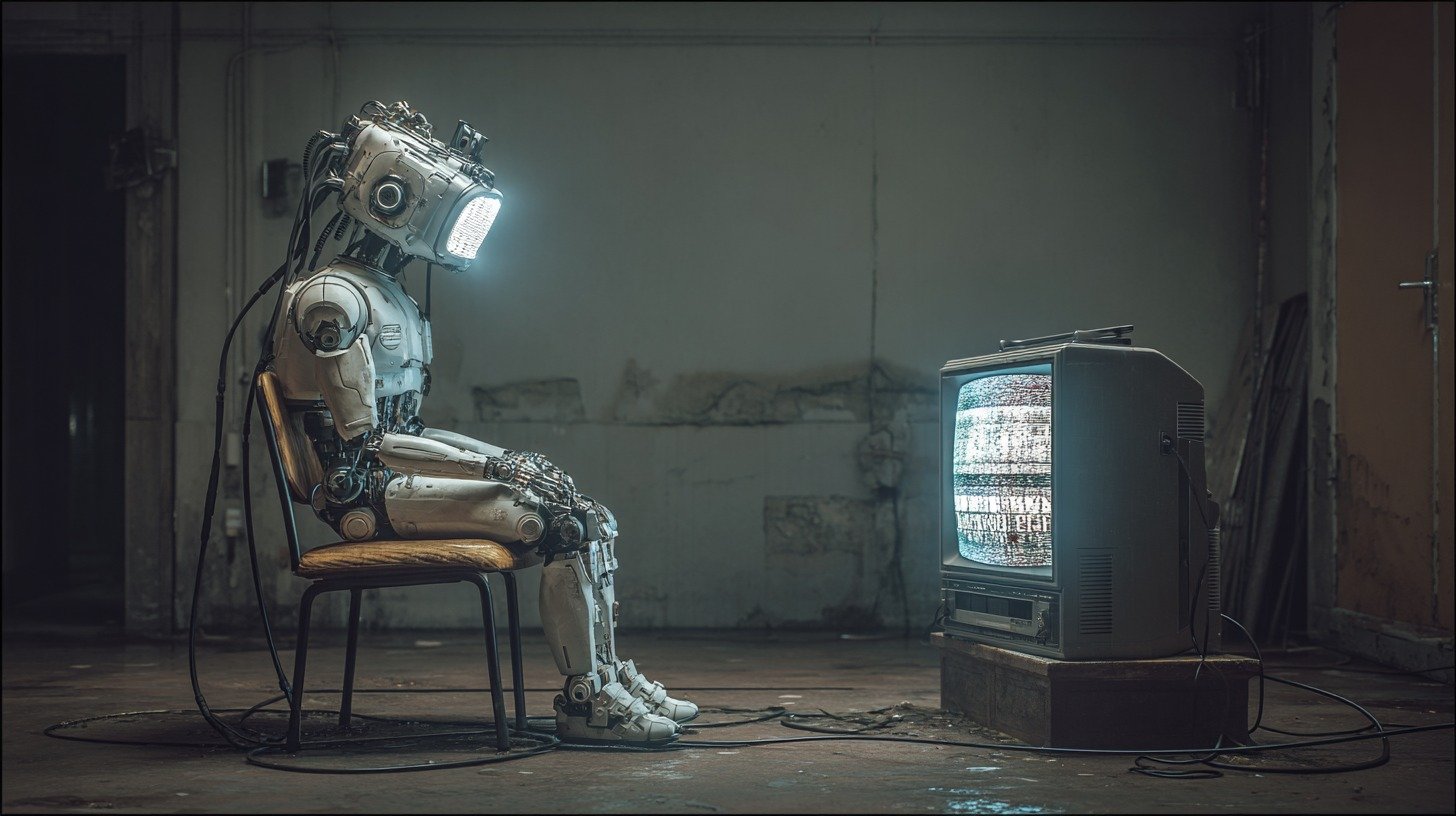

El intermediario invisible

La brecha entre nuestra intención y la experiencia real del usuario es cada vez más evidente. Piensa en el esfuerzo que supone diseñar una landing page perfecta, clara, persuasiva, optimizada. El problema es que muchos de tus usuarios potenciales nunca la ven. En su lugar, interactúan con el resumen que ChatGPT hace de tu propuesta de valor, mezclado con información de tus competidores y reinterpretado para su conversación.

La situación se vuelve aún más impredecible con las interfaces que no controlamos. Creas una aplicación con un flujo de usuario cuidadosamente pensado, pero la mayoría de las interacciones llegan a través de Siri o Gemini. Estos asistentes preseleccionan qué funciones mostrar y en qué orden, basándose en patrones ajenos a tu diseño. Y de repente, tu cuidada experiencia visual se ha convertido en una interacción de audio. Un formato para el que ni siquiera habías diseñado tu producto.

Y luego está el contenido que publicas. Aunque esté estratégicamente diseñado para tu audiencia, es el algoritmo de LinkedIn o Twitter quien tiene la última palabra. Decide si alguien lo ve, cuándo lo ve, y junto a qué otros contenidos aparece, alterando completamente el contexto y la percepción de tu mensaje.

En todos estos casos, hay un intermediario que no habíamos considerado en nuestros user journeys, personas o wireframes. Un agente que tiene sus propios criterios, sesgos y objetivos. Que no es neutral.

Lejos de ser un simple canal de distribución, la IA actúa como un intérprete activo que traduce, filtra y recontextualiza todo lo que creamos. Y esa traducción puede ser fiel… o completamente distorsionada.

El peligro de olvidar al beneficiario

Frente a esta nueva realidad, la tentación es simple: si la IA es el nuevo intermediario, entonces diseñemos para la IA. Optimicemos para la legibilidad algorítmica. Estructuremos todo para que las máquinas nos entiendan mejor.

Es lógico. Es pragmático. Y es exactamente donde empiezan los problemas.

Cada vez es más frecuente que el discurso y las prioridades se desplacen. El éxito consiste en que nuestro contenido «rankee bien». La nueva meta es que los algoritmos nos «entiendan», así que el trabajo se centra, simplemente, en que nuestros datos estén «correctamente estructurados». El foco se desplaza hacia la propia IA como si fuera el objetivo final. El «beneficiario» pasa a ser la máquina, no el humano al otro lado.

La lógica se vuelve recursiva. Optimizamos para la IA para que la IA nos optimice mejor. El beneficio humano queda cada vez más lejos, mediado por capas de interpretación algorítmica que no controlamos.

Es como si hubiéramos pasado de hablar directamente con alguien a susurrarle cosas a un traductor que luego decide qué, cómo y cuándo contárselo a esa persona. Y en lugar de preocuparnos por lo que llega al final, nos obsesionamos con hablarle bien al traductor.

¿Qué significa que algo funcione bien?

En muchas reuniones a lo largo de mi carrera, he visto cómo algunas discusiones sobre diseño o producto acaban con una frase que suena conciliadora: «bueno, lo importante es que funcione bien». Todos asienten, parece una forma sensata de cerrar el debate. Pero con el tiempo he aprendido que detrás de esa frase se esconde un problema serio.

Porque cada persona entiende «bien» de una manera distinta. Para un programador, puede significar que las acciones generen la reacción esperada. El equipo comercial lo mide en ventas. Desde la perspectiva de UX, «bien» es que el flujo sea intuitivo, mientras que para el diseñador visual se trata de que todo esté en equilibrio. Y para el usuario… la definición depende de quién sea, del momento y de lo que espera o necesita.

Yo he aprendido a no dejar pasar esa frase tan fácilmente. A romper, si hace falta, ese momento de falso consenso y preguntar: ¿qué significa exactamente «bien»? ¿Para quién? ¿Desde qué criterio lo estamos midiendo?

Ahora que la IA entra en juego, esta ambigüedad se vuelve peligrosa. Porque un sistema puede estar «funcionando bien» desde múltiples perspectivas simultáneamente… y contradictorias.

Imagina un algoritmo de noticias. Desde la perspectiva de la plataforma, «funciona bien» porque maximiza el tiempo que pasas leyendo. La propia IA lo considera un éxito, al predecir con precisión qué te va a enganchar. Para el anunciante, el beneficio es claro, ya que segmenta perfectamente tu perfil. El problema es que para ti, como persona, el resultado es un aislamiento progresivo en una burbuja de confirmación.

¿Está funcionando bien? Depende de tu perspectiva. Cuando hay un intermediario tan poderoso como la IA, el funcionar «bien» de la máquina puede estar perfectamente alineado con el sentirse «mal» del humano.

Un algoritmo que te recomienda música basándose solo en tus gustos previos está funcionando de maravilla… si el objetivo es predecir qué te va a gustar. Pero está fallando estrepitosamente si el objetivo es expandir tu horizonte musical.

Un sistema de recomendaciones de trabajo que te muestra solo ofertas similares a tu experiencia previa es un éxito algorítmico… y un fracaso si lo que necesitas es evolucionar en tu profesión.

Este comportamiento no son errores del sistema. Son casos donde el sistema funciona exactamente como está diseñado, pero los objetivos del algoritmo y los objetivos humanos han quedado desalineados.

Recuperar el control de la conversación

No creo que la solución sea resistirse a la IA o pretender que no existe o no nos afecta. Pero sí creo que tenemos que ser mucho más conscientes de lo que significa diseñar en un mundo mediado por algoritmos.

Tenemos que empezar a reconocer que ya no diseñamos directamente para personas. Diseñamos para un sistema híbrido: humano + IA + contexto. Y ese sistema tiene sus propias dinámicas, sesgos y puntos ciegos. Porque optimizar para la legibilidad algorítmica no es neutro. Cada vez que estructuramos información para que una máquina la entienda mejor, estamos tomando decisiones sobre qué aspectos de la experiencia humana son importantes y cuáles no. Así que necesitamos nuevas formas de definir qué significa que algo «funcione bien» cuando hay un intermediario tan poderoso en el medio. Formas que vayan más allá de la eficiencia algorítmica y consideren el impacto real en las personas.

Mi postura es que debemos adoptar un posicionamiento humanista en el diseño. En mi experiencia, esto significa ser esa persona que, en las reuniones, rompe el consenso fácil del «funciona bien» al plantear preguntas clave: ¿Cómo va a interpretar la IA lo que estamos creando? ¿Qué se va a perder en esa traducción? ¿Qué elementos de la experiencia humana no puede capturar o transmitir un algoritmo?

Y sobre todo, ¿quién define realmente qué es valioso cuando la IA es quien decide qué información llega al usuario y cómo se presenta? Porque si no somos nosotros quienes tomamos esas decisiones conscientemente, las tomará el algoritmo por nosotros. Y sus criterios pueden estar muy lejos de lo que realmente necesitamos.

De cómo esas decisiones algorítmicas empiezan a moldear no solo lo que vemos, sino lo que queremos, hablaré en el próximo artículo.